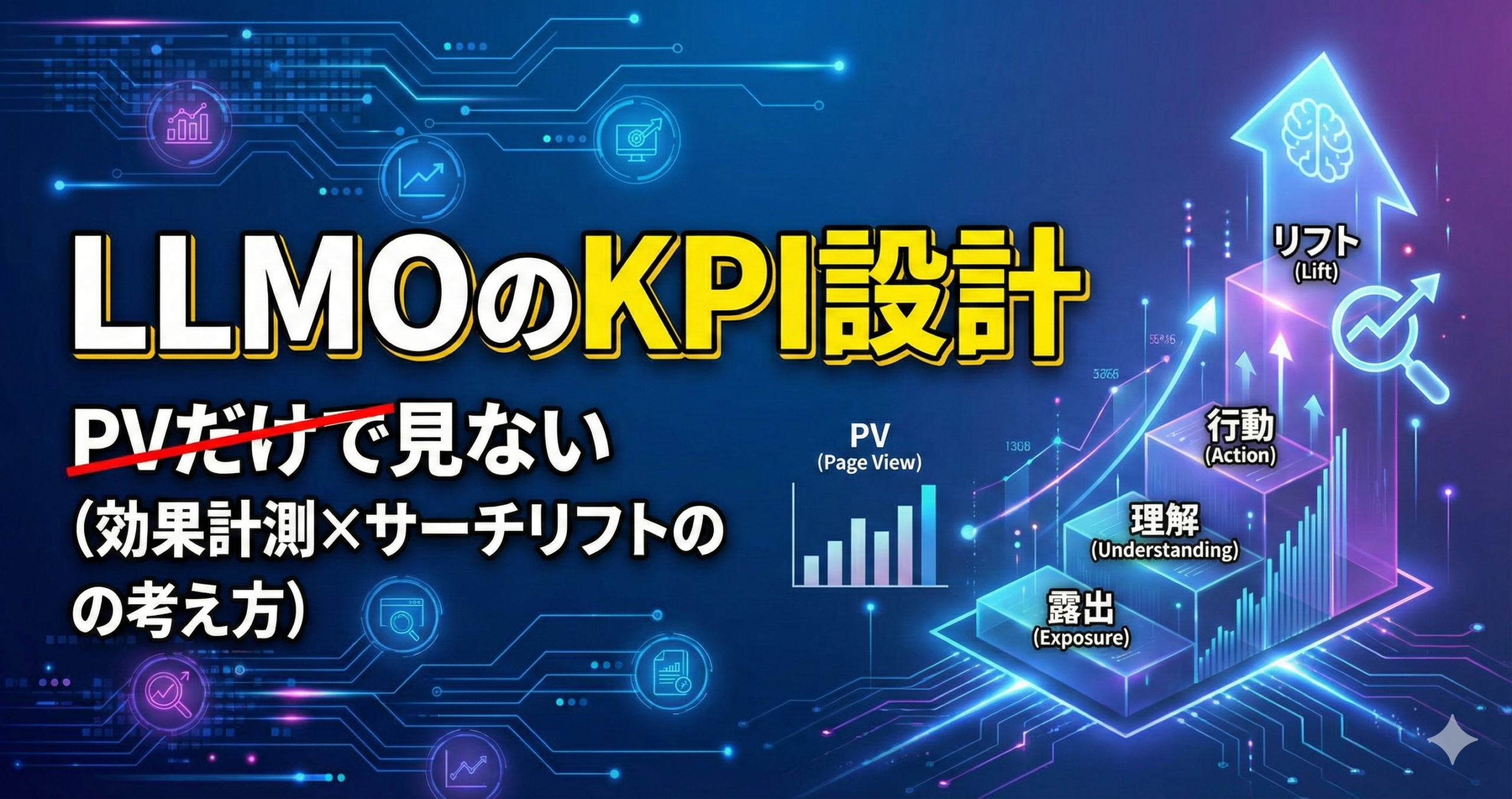

LLMOのKPI設計:PVだけで見ない(効果計測×サーチリフトの考え方)

LLMO(大規模言語モデル最適化)を意識したコンテンツ運用では、PVだけを見ていると、判断がぶれたり、改善の方向が揃いにくくなったりします。

理由はシンプルで、LLMOの成果は「読まれたか」だけではなく、“参照されたか/信頼されたか/思い出されたか”といった中間の変化が積み上がって出やすいからです。本記事では、PVに偏らないKPI設計の考え方を、設計→運用→改善の形で落とし込みます。

イントロダクション

“KPIリスト運用が感覚頼みになりやすい理由”と、“MA×データ×スコアリングで何が変わるか”を提示します。

LLMOのKPI設計は、気づくと「PVが増えた/減った」で会話が終わりがちです。PVは分かりやすい一方で、LLMOの成果の出方(検索・生成回答・要約・比較検討など)の多様さを吸収しきれないことがあります。

このときKPIリスト運用が感覚頼みになる理由は、“何を成果とみなすか”がチーム内で揃いにくいからです。編集は「引用される情報の質」、広告・CRMは「行動の兆候」、営業は「問い合わせの質」と見ているものが違い、PVだけを共通言語にすると、重要な中間変化が見落とされやすくなります。

そこで役立つのが、MA×データ×スコアリングの考え方です。ここでいうMAは、配信自動化だけではなく、計測と改善を“運用フロー”に組み込むための仕組みと捉えます。データは閲覧や問い合わせだけでなく、検索の変化や現場の声なども含めた材料です。スコアリングは、各指標を“次の打ち手”につなげるための優先順位付けです。

PVだけで判断 → 中間指標を追加 → リフトで検証 → 運用で定着

PVは“入口”としては有用です。ただしLLMOでは、入口の後に起きる「理解」「想起」「比較」「指名検索」などが効いてくることがあるため、PVだけに寄せると意思決定が荒れやすい、という話です。

[画像案]LLMOの成果が「PV→信頼→行動→リフト」と積み上がる図

例:階段のイラストに「露出」「理解」「行動」「リフト」を配置。PVは露出の一部として置き、上段ほど“遅れて効く”注釈を付ける。

- PVは入口の指標として有用ですが、LLMOの成果を説明し切れない場面があります。

- KPIリスト運用が感覚頼みになりやすいのは、チームごとの“成果観”がずれるからです。

- MA×データ×スコアリングで、計測→判断→改善を運用に埋め込むと回りやすくなります。

概要

用語を噛み砕いて整理し、掛け合わせると「運用」単位で何が変わるかを具体化します。

用語整理:MA / オルタナティブデータ / AIスコアリング

MA(マーケティングオートメーション)

配信の自動化だけでなく、リードの状態に合わせて「次の情報」を変える仕組みです。LLMOでは“誰が何を理解したか”の文脈づくりにも使われます。

オルタナティブデータ

サイト内の行動やCRM以外にも、検索の変化、問い合わせの論点、営業・CSの反論など、状況変化の兆候を扱う材料です。LLMOの“効き方”を説明しやすくなります。

AIスコアリング

複数の指標や兆候を束ね、優先順位や対応の分岐に落とす考え方です。LLMOでは「改善すべき記事」「増やすべき論点」を運用で選別しやすくなります。

サーチリフト(考え方)

露出や接触によって、指名・関連の検索行動や想起が変化したかを捉える観点です。PVが伸びない時でも、後から効く変化を説明しやすくなります。

掛け合わせると、何が「運用」単位で変わるのか

LLMOのKPIを設計するときは、指標そのものより、“指標が動いたら何をするか”まで決めると運用が安定します。MA×データ×スコアリングを掛け合わせると、次のように運用単位の意思決定が揃いやすくなります。

KPIを眺めるだけだと、議論が抽象化しがちです。「この指標が下がったら見出しを直す」「この兆候が出たら比較表を増やす」のように、介入の型まで用意すると迷いが減ります。

- ターゲティング:読者属性より「検索意図・比較論点・不安」を軸に記事群を再編しやすくなります。

- 優先順位:PVが高い記事ではなく「引用される根拠が弱い記事」「誤解が生まれやすい論点」などに手を入れやすくなります。

- ナーチャリング:記事接触後の関心の深まりを、段階別に観測して出し分けしやすくなります。

- 営業連携:記事で増えた質問・反論を、次のコンテンツ改善や商談資料に戻しやすくなります。

利点

“精度”ではなく“運用の再現性”に焦点を置いて、改善されやすいポイントを整理します。

LLMOのKPIをPV中心から広げると、成果が出るまでの道筋を説明しやすくなります。ここで重要なのは、何か一つの指標を「正解」にすることではなく、判断の材料を増やして、再現性のある運用に寄せることです。

属人化しやすい評価が揃いやすい

編集・広告・営業で見るものが違っても、段階別のKPIがあると「今どこが詰まっているか」を共通言語にしやすいです。

優先順位のズレが減りやすい

PVが低い記事でも「信頼の根拠」や「比較論点」の役割がある場合があります。役割別に評価できると、改善の順番を決めやすくなります。

温度感の誤判定が起きにくい方向に寄せられる

PVは“接触”の話ですが、商談の準備や比較検討は別の動きで現れます。中間指標を置くと、温度感の見立てが安定しやすいです。

説明責任を取りやすい

PVだけだと「なぜ良いのか/悪いのか」が曖昧になりがちです。リフトや兆候を併用すると、改善の仮説が立てやすくなります。

指標が多いほど良い、という話ではありません。増やした指標が運用に結びつかないと、見る工数だけが増えます。「見たら動ける指標」から順に採用するのが無難です。

- PV中心から段階別に広げると、成果の道筋が説明しやすくなります。

- 再現性の観点では「見る指標」より「動くルール」が重要になりやすいです。

- 指標は増やしすぎず、運用に接続できるものから採用するのが無難です。

応用方法

代表ユースケースを提示しつつ、“どのデータを使い、どう特徴量に落とすか”を概念レベルで解説します。

ユースケース:リード獲得後のスコアで配信シナリオを分岐

LLMOの文脈では、記事で得られるのは「接触」だけではありません。比較検討の論点が整理されたり、用語が理解されたりすることで、その後の行動が変わることがあります。そこで、記事接触後の状態をスコアとして扱い、MAのシナリオを分岐させると、PVの上下に左右されにくい運用になります。

スコアは「買う/買わない」を断定するためではなく、次に渡す情報の種類を選ぶ材料として扱うと安全です。例外処理(保留、追加質問、別ルート)も先に決めておくと運用が回りやすいです。

ユースケース:営業アプローチ順の最適化(判断基準として)

LLMOでは、読者が「社内説明の準備」をしている段階で記事を読むこともあります。PVだけだとこの状態が見えにくいので、問い合わせや商談前の兆候(資料閲覧、比較記事の接触、用語解説の読み込みなど)を束ね、アプローチ順の判断基準にします。ここでも断定は避け、優先度の目安として扱うのが現実的です。

ユースケース:休眠掘り起こし(反応兆候の取り方)

休眠層は、PVの増減だけで判断すると打ち手が単調になりがちです。そこで「反応の質」を兆候として扱い、反応が見えた人だけに、比較論点や導入条件の整理コンテンツを届ける運用にすると、過剰な配信を避けやすくなります。

どのデータを使い、どう特徴量に落とすか(概念)

LLMOのKPIをPVだけで見ないためには、データを「段階」に合わせて束ねるのがコツです。ここでは数字は置かず、分類の考え方を示します。

露出の手がかり

記事が見つかったか、入口が機能しているかの材料です。PVはここに含まれますが、入口は複数ある前提で捉えます。

理解の手がかり

用語の理解、比較軸の整理、誤解の解消など。滞在やスクロールのような単純な動きだけでなく、内容の“読みどころ”に着目します。

行動の手がかり

資料請求、問い合わせ、導線の遷移、再訪など。単発の反応ではなく、次の行動につながる連続性を見ます。

リフトの手がかり

指名や関連の検索行動、想起の変化、商談での質問の質など。PVが伸びない時でも効きやすい変化を拾います。

[画像案]KPIツリー(露出→理解→行動→リフト)

例:ツリー図の根に「コンテンツ」、枝に「露出」「理解」「行動」「リフト」。各枝に代表指標の付箋を貼り、最後に「運用アクション」欄を設ける。

- ユースケースは「分岐」「優先度」「掘り起こし」のように、運用の意思決定単位で捉えると回りやすいです。

- 特徴量は段階に合わせて束ねると、PV偏重を避けやすいです。

- リフトは“後から効く変化”を拾う観点として、KPI設計に入れておくと説明が楽になります。

導入方法

導入を「設計→データ→モデル→運用→改善→ガバナンス」で分解し、チェックリスト形式で示します。

設計:目的とKPIを段階で定義する

まず、LLMOで何を良くしたいのかを段階で整理します。PVは入口の議論に寄りやすいので、入口だけでなく、理解・行動・リフトまでの道筋を言語化します。ここで重要なのは、各指標が“何のため”なのかが説明できることです。

- 目的は「認知」「理解」「比較」「指名」「商談準備」のように段階で置くと整理しやすいです。

- KPIは「観測」だけでなく「動くルール」までセットで決めると運用が安定しやすいです。

- MQLや優先度、営業SLAは“成果観のズレ”を埋めるために先に合意します。

データ:名寄せ、欠損、更新頻度、粒度を整える

次に、KPIを支えるデータの扱いを整えます。指標の種類が増えるほど、データの粒度や更新タイミングの違いが運用負荷になりやすいです。完璧を狙うより、運用に必要な最低限の整合性から始めるのが無難です。

-

データの粒度を揃える

記事単位、テーマ単位、導線単位など、意思決定に使う単位を先に決めます。単位が揺れると会話が噛み合いにくくなります。

-

欠損の扱いを決める

取れない指標がある前提で、代替の見方(近い兆候)を用意します。欠損は“ゼロ”と同義にしないほうが安全です。

-

更新頻度の違いを設計に入れる

入口は早く動き、リフトは遅れて動くことがあります。判断タイミングの期待値を揃えると、焦って判断しにくくなります。

-

現場データの取り込み口を作る

営業・CSの反論や質問は、リフトの兆候として有用です。テキストで記録できる仕組みを用意すると改善に戻しやすいです。

モデル:スコアの使い方(しきい値、分岐、例外処理)

スコアリングは、指標を一つに集約するためではなく、運用の判断を揃えるために使うと安全です。しきい値は暫定として置き、例外処理を先に決めます。例外処理がないと、スコアが“正解の押し付け”になりやすく、現場が止まりがちです。

例外処理は「手動レビュー」「追加の質問を挿入」「別シナリオに回す」などで構いません。重要なのは、スコアが外れたときの逃げ道を、運用手順に含めることです。

- スコアは“断定”ではなく“分岐”に使うほうが、現場で揉めにくいです。

- 例外は失敗ではなく、モデル改善の材料として記録します。

- しきい値は固定せず、見直し前提にします。

運用:運用担当・営業・CSの役割を決める

LLMOのKPIは、編集だけで閉じると偏りやすいです。営業・CSが持つ“現実の論点”を計測と改善に戻すと、リフトの説明がしやすくなります。役割分担は、責任の押し付けではなく、改善ループを回すための分業として設計します。

編集:根拠と構造 → 運用:計測と分岐 → 営業/CS:現場論点 → 改善:更新ログ

- 編集は「引用される根拠」や「誤解が生まれない構造」を担うと整理しやすいです。

- 運用は「計測の整合性」と「分岐ルール」を担うと、迷いが減りやすいです。

- 営業・CSは「実際の反論・質問」を例外として蓄積すると、改善が加速しやすいです。

改善:ドリフト、誤判定、再学習の考え方

LLMOの運用では、トレンドや比較軸が変わることで、記事の効き方が変わることがあります。ここでは未来を断定せず、変化が起きる前提で品質管理を設計します。ドリフトは、指標が下がった時だけではなく、“論点がズレた”時に起きやすいと捉えると現場で扱いやすいです。

-

ドリフトのサインを決める

検索意図の変化、質問の変化、比較軸の変化などを“兆候”として扱います。PVが維持されていても、兆候が変わることがあります。

-

誤判定の影響を小さくする

しきい値で一気に振り分けるのではなく、段階別に分岐する設計にすると、外れたときの損失を抑えやすいです。

-

再学習は“周期”より“条件”で考える

一定期間で見直すのも有効ですが、論点が変わった兆候が出たら見直す、という条件ベースも現実的です。

-

更新ログを残す

何を変えたか、なぜ変えたか、どの兆候が根拠かを残すと、改善が属人化しにくくなります。

ガバナンス:ブラックボックス化、運用負荷、過学習“っぽい”兆候

KPIが増え、スコアリングが入ると、ブラックボックス化が心配になることがあります。ここでの対策は、モデルの中身を完璧に説明するより、運用の透明性を上げることです。入力、例外、更新の記録があると、現場が納得しやすくなります。

特定のテーマにしか当てはまらない説明が増える、例外が増えるのにルールが更新されない、現場の反論が溜まる――といった兆候が見えたら、入力の見直しや例外処理の強化から入ると手戻りが減りやすいです。

[画像案]計測ガバナンスのチェックシート(手書き風)

例:「定義」「収集」「更新」「例外」「共有」の付箋を並べ、各付箋に“やること”を一言で書く。最後に「責任者」欄を置く。

- 導入は「設計→データ→モデル→運用→改善→ガバナンス」の順で分解すると抜け漏れが減りやすいです。

- 例外処理と更新ログは、ブラックボックス化を避けるうえでも有効になりやすいです。

- リフトは“遅れて効く”ことがある前提で、判断タイミングを設計に入れるのが無難です。

未来展望

AIスコアリングが一般化すると何が標準化されるかを、運用・組織・データ観点で整理します。未来は断定せず可能性として述べます。

AIスコアリングが一般化すると、LLMOのKPI設計も「PV中心」から「段階別」へ移る流れが強まるかもしれません。そのとき標準化されやすいのは、指標そのものより、運用手順と記録の部分です。

運用で標準化されやすいこと

KPIツリー、分岐の型、例外処理、更新ログ、品質レビューの観点など。再現性に直結する要素が中心です。

組織で標準化されやすいこと

編集・運用・営業・CSをつなぐフィードバック回路。現場論点を“例外”として戻す運用が整うと、リフトの説明がしやすくなります。

データで標準化されやすいこと

段階別のイベント定義、テーマ分類、問い合わせの論点タグなど。意味のある単位で揃うと、スコアリングが運用に乗りやすいです。

独自性が残りやすいこと

一次情報の作り方、根拠の設計、読者の不安の捉え方、現場の例外の扱い方。標準化の上で“何を入れるか”が差になりやすいです。

LLMOの評価は、単一の指標で完結しにくい可能性があります。そのため、段階別のKPIと、リフトを含む検証の仕組みが、より重要になるかもしれません。

- 標準化が進むほど、指標の選び方より運用手順と記録の品質が効きやすくなります。

- 組織連携が弱いと、リフトの兆候が拾えず、PV偏重に戻りやすいです。

- 独自性は“表現”より“根拠と例外の扱い”に残りやすいです。

まとめ

本記事の要点を簡潔に再整理し、次アクションは「小さく始める」方針で提示します。

LLMOのKPI設計では、PVを入口として活用しつつ、理解・行動・リフトまで段階を分けて捉えると、運用の再現性が上がりやすくなります。特に、サーチリフトの考え方を入れることで、PVが伸びない局面でも“効いている変化”を説明しやすくなります。

小さく設計 → 最低限の計測 → 分岐と例外 → リフトで検証

- PVは入口の指標として有用ですが、LLMOの成果を説明し切れない場面があります。

- KPIは「露出・理解・行動・リフト」のように段階を分け、運用アクションまでセットで設計すると回りやすいです。

- MA×データ×スコアリングで、計測→判断→改善を運用フローに埋め込むと属人化が減りやすいです。

- まずは用途を絞った小さな検証から始め、例外処理と更新ログを整えながら広げるのが無難です。

FAQ

初心者がつまずきやすい質問を中心に、断定せず「判断の軸」「確認事項」を提示します。

PV以外に、まず何を追加で見ればよいですか?

最初は、段階別の中でも「理解」か「行動」に関わるものからが扱いやすいです。いきなり多くを追わず、見たら動ける指標を選ぶのが無難です。

- 記事の役割(用語理解/比較整理/社内説明)を言語化できているか

- 役割に沿った“次の行動”を定義できているか

- その行動に近い兆候を観測できるか

サーチリフトは、何を見れば「変化」と言えますか?

ここでは断定せず、考え方として整理します。指名や関連の検索行動、想起の変化は、単発よりも継続性や文脈で捉えると扱いやすいです。

- 指名や関連の検索が“継続して”増える兆候があるか

- 商談や問い合わせで出る論点が変わっているか

- 比較軸が整理され、説明が短くなっている兆候があるか

LLMOのKPIは、どの粒度で持つのがよいですか?

記事単体で持つと改善がしやすい一方、テーマ単位や導線単位の視点も必要になります。まずは意思決定の単位を決め、粒度が揺れないようにするのが無難です。

- 改善は記事単体、評価はテーマ単位、のように役割分担できているか

- 粒度が違う指標を同列に比較していないか

- 導線単位のKPI(記事群→次アクション)が定義できているか

スコアリングは怖いです。ブラックボックス化を避けるには?

モデルの中身を完璧に説明するより、運用の透明性を上げるのが現実的です。入力・例外・更新を記録し、現場が「違う」と言える窓口を用意すると改善しやすくなります。

- スコアの用途が分岐に限定されているか

- 例外処理(手動レビュー等)が設計されているか

- 更新ログが残る運用になっているか

営業・CSの声をKPIに入れると、主観になりませんか?

主観が混ざること自体は避けにくいので、扱い方を決めるのがポイントです。意見を“結論”にせず、例外や兆候として蓄積し、一定の期間で傾向を見ると実務に落としやすいです。

- 質問や反論をカテゴリ(論点)で整理できているか

- 同じ論点が繰り返し出ているか

- その論点を記事の根拠や構造に反映できるか

改善の優先順位は、どう決めればよいですか?

PVが高い記事から手を入れると、改善が分かりやすい一方で、LLMOでは“根拠の弱さ”や“誤解の生まれやすさ”がボトルネックになることがあります。段階別のKPIで、どこが詰まっているかを見て決めるのが無難です。

- 入口(露出)が弱いのか、理解(構造・根拠)が弱いのか

- 行動(導線・次アクション)が弱いのか

- リフト(想起・検索・論点)の兆候が弱いのか

小さく始める場合、最初の設計はどう切り出せばよいですか?

最初は「テーマを一つ」「記事群を少数」「次アクションを一つ」に絞ると運用が回りやすいです。指標も段階別に最小構成で置き、例外処理と更新ログを先に整えます。

- 対象テーマの“読者の不安・比較軸”を言語化できているか

- 段階別のKPIを最小構成で置けているか

- 見たら動けるアクションが決まっているか

- PV以外の指標は、段階に合わせて少しずつ増やすのが無難です。

- リフトは“後から効く変化”を拾う観点として、説明と改善に役立ちやすいです。

- ブラックボックス化は、例外処理と更新ログで抑えやすいです。

免責:本記事は一般的な考え方の整理です。業種・商材・組織体制・計測環境によって最適な設計は変わり得るため、現場の状況に合わせて調整してください。

「IMデジタルマーケティングニュース」編集者として、最新のトレンドやテクニックを分かりやすく解説しています。業界の変化に対応し、読者の成功をサポートする記事をお届けしています。

-7-320x180.png)

-2025-09-05T151236.591-320x180.png)