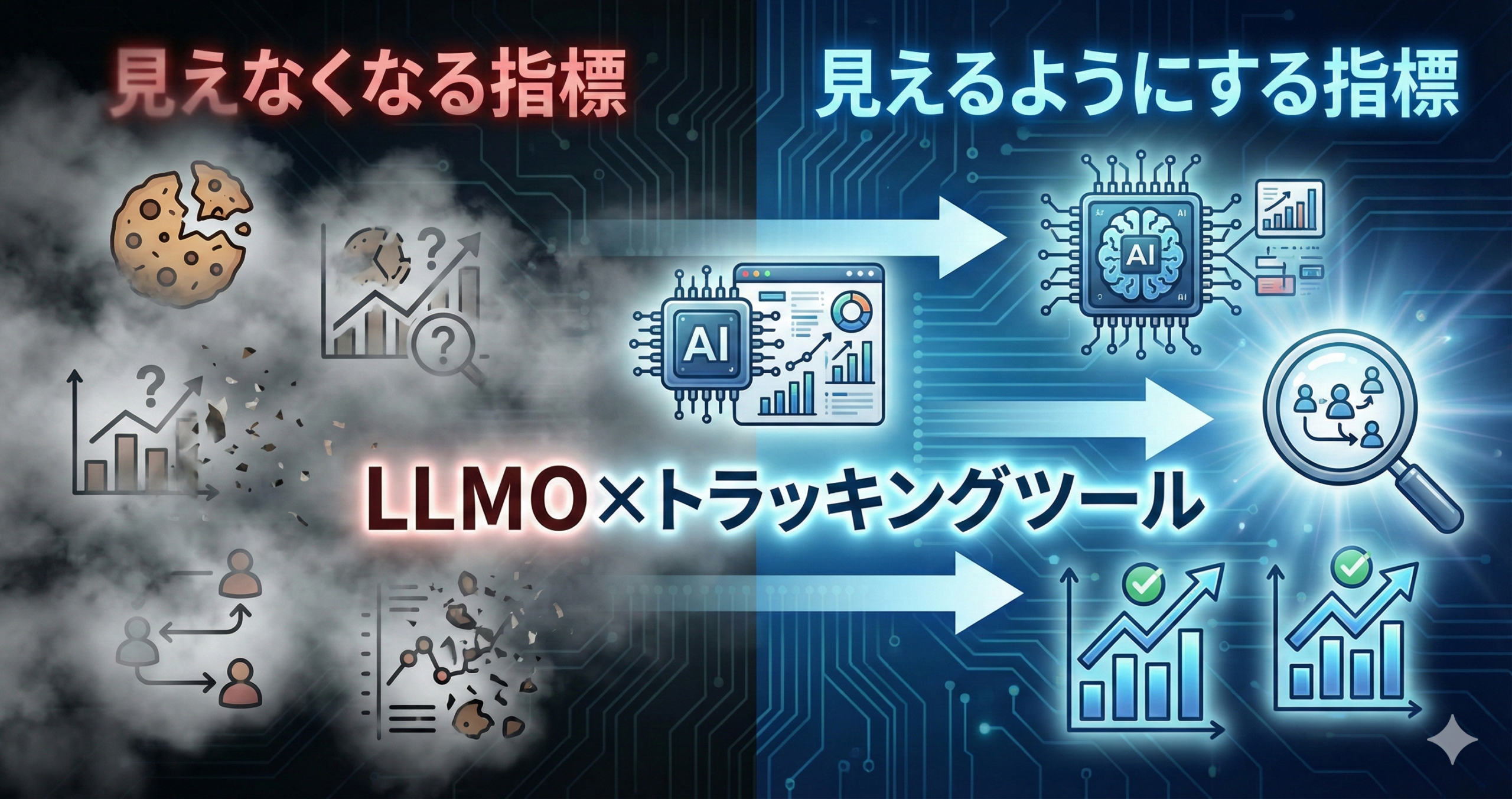

LLMO×トラッキングツール:見えなくなる指標、見えるようにする指標

生成AIの利用が広がるにつれ、ユーザーが情報に触れる経路は多様化しています。

その結果、従来の“検索流入を中心にした見方”だけでは、マーケティングの成果を捉えにくくなる場面が増えています。

本記事では、LLMO(生成AI最適化の考え方)を前提に、見えにくくなる指標と見えるように設計できる指標を整理し、トラッキングツールをどう使い分けると運用しやすいかを解説します。

🧭イントロダクション

LLMOは“検索順位”の話で終わらず、計測の考え方にも影響する

LLMOという言葉は、「生成AIに引用されるための最適化」として語られがちです。

しかし実務では、もう一段深い変化があります。

それは、トラッキングで“当たり前に見えていた指標”が、見えにくくなることです。

🔍 “検索”に見えない接点が増える

ユーザーはAIの回答で要点を掴み、必要なときだけサイトに来る。

🧾 “参照”の形が変わる

クリックの前に理解が進むため、従来の指標だけだと価値が捉えにくい。

🧩 経路が複雑になり、因果が短絡しやすい

「この流入=成果」と言い切りにくく、説明の難易度が上がる。

🤝 社内合意に“計測の言葉”が必要になる

見えにくい部分を、プロキシ指標やログで補う設計が求められる。

🗣 現場で起きやすいズレ

「検索流入が落ちた=施策が失敗」と判断してしまう。

でも実際は、AI経由で理解が進み、来訪は減っても商談は増えている…というケースも起こり得ます。

LLMOをやるなら、計測も“前提”から作り直す必要があります。

これからは、見えなくなる指標を嘆くより、見えるようにする指標を設計する方が成果につながります。

その鍵は、イベント(行動)と意思決定(判断)をつなぐ“指標の翻訳”です。

🧩概要

「見えにくい」は“取得不能”ではなく、“意味が取りづらい”ことが多い

LLMOの文脈で「指標が見えなくなる」と言うと、データが取れない印象になりがちです。

ただし実務では、次の2タイプに分かれます。

🌫 見えにくい(意味が取りづらい)

データはあるが、解釈が難しく、意思決定に使いにくい。

🕳 見えない(欠損・非観測)

計測できていない、または粒度が粗すぎて判断に使えない。

従来は「行動指標」だけでも改善が回りました。

しかし今後は、AIで理解が先に進む分、接点指標を設計して補うことが重要になります。

| 層 | 見えにくくなる理由 | 見えるようにする方向性 |

|---|---|---|

| 接点指標 | 理解が“来訪前”に進むため、従来の流入指標だけでは不足 | 検索以外の接点ログ、指名/再訪/深い閲覧などのプロキシ |

| 行動指標 | 来訪が減っても、目的来訪が増えると指標の意味が変わる | マイクロコンバージョン、ステップ到達、品質スコア |

| 成果指標 | 経路が複雑化し、単純な“最後の接点”で説明しにくい | 意思決定ログ、リード品質、営業プロセスの整備 |

この記事では「Cookie配信」には触れません。

代わりに、ツールや計測の一般的な設計論として、指標の作り方と運用の型にフォーカスします。

✨利点

指標が整理されると、LLMO施策が“評価できる施策”になる

LLMO関連施策は、やること自体は多岐にわたります(構造化、一次情報、表現の整備、引用されやすい要約など)。

しかし評価が曖昧だと、社内で継続しにくくなります。

指標設計を先に整えると、次の利点が得られます。

🧾 説明しやすい

「何が増えた/減ったか」だけでなく、「なぜそう言えるか」を語りやすい。

🔁 改善が回りやすい

接点→行動→成果のどこが詰まっているか切り分けできる。

🤝 関係者と合意しやすい

代理店・制作・営業など、部門間で“同じ指標”を見られる。

🧠 AI活用につながる

整ったイベントと品質チェックがあると、分析・自動化の精度が安定しやすい。

🧰応用方法

「見えなくなる指標」を“役割の変化”として再定義する

ここでは、トラッキングで扱う指標を「見えにくくなるもの」と「見えるようにするもの」に分けて整理します。

大事なのは、捨てるのではなく、役割を変えることです。

見えにくくなる指標(そのままでは判断に使いにくい)

📉 検索流入数 役割が変わる

流入数は重要ですが、AI経由で理解が進むと、来訪が“目的来訪”へ寄ります。

その結果、単純な増減だけでは成果を説明しづらくなることがあります。

🖱 CTR(クリック率) 比較が難しい

表示のされ方が多様化すると、CTRの意味が揺れます。

“クリックの前に理解が進む”と、CTRは下がっても成果が落ちない場合があります。

⏱ 滞在時間 解釈が割れる

短くても目的達成しているケースと、読み飛ばしているケースが混ざります。

単独では判断しづらく、補助指標とセットが必要です。

📄 PV 品質が混ざる

PVは全体の熱量を示しますが、AI時代は“必要なページだけ読む”来訪も増えます。

PVは「量」指標として残しつつ、「質」指標を足すと安定します。

これらの指標が「不要」になるわけではありません。

ただし、単独で意思決定をするとブレやすいため、補助指標(プロキシ)で意味を補う設計が重要です。

見えるようにする指標(LLMO時代の“翻訳指標”)

LLMOの評価を安定させるには、「接点の質」「理解の進み」「意思の強さ」を示す指標が有効です。

ここで使うのが、プロキシ指標です。

接点の質

🏷 指名・ブランド系の動き

指名検索、ブランド名の参照、再訪など。理解が進んだ兆候として扱いやすい。

理解の進み

🧭 深い閲覧・比較行動

料金/仕様/導入事例など、判断に近いページへの到達や回遊をイベント化。

意思の強さ

🧾 マイクロCV

資料DL、デモ動画視聴、フォーム到達、入力開始など。成果の前段として扱う。

トラッキングツールの役割分担(一般的な整理)

ツールは万能ではありません。役割で分けると混乱が減ります。

ここでは、一般的な区分として整理します(特定製品に依存しない形です)。

| ツール領域 | 得意なこと | LLMO時代の使いどころ |

|---|---|---|

| アクセス解析 | 全体像の把握、イベント集計、ファネル分析 | プロキシ指標の可視化、主要導線のボトルネック発見 |

| 検索系レポート | 検索露出・クエリ傾向の把握 | 指名/非指名の変化、テーマ別の伸び縮みの把握 |

| タグ管理 | イベント実装の管理、発火条件の統制 | イベント辞書に沿った実装、変更の影響範囲の管理 |

| CRM/MA | リード以降の追跡、属性付与、スコアリング | 成果の“質”を可視化し、プロキシ指標と接続する |

| BI/データ基盤 | 横断集計、履歴管理、意思決定の説明 | 接点→行動→成果を一本のストーリーで語れる形へ |

ツールを増やす前に、指標の定義(辞書)とイベントの粒度を揃える方が効果が出やすいです。

ツールは“入れ替え”より、“役割分担”の再設計で改善する場面が多いです。

🏗導入方法

最初は「棚卸し→プロキシ設計→イベント実装→品質監視」の順で進める

LLMO×トラッキングは、いきなり大改修すると運用が崩れやすいです。

まずは“既存指標の棚卸し”から始め、足りない部分をプロキシ指標で補う進め方が現実的です。

🪜 導入ステップ(実務向け) 小さく整える

いま見ている指標を「接点」「行動」「成果」の3層に分類します。

“どの意思決定に使う指標か”が曖昧なものは、役割の再定義が必要です。

検索流入やCTRなどの変動に対して、深い閲覧・比較行動・マイクロCVなどをセットで定義します。

重要なのは、増やしすぎず「判断に必要な最小限」にすることです。

“プロキシ指標を支えるイベント”を辞書化します。

イベント名・発火条件・必須パラメータ・集計上の注意を、最低限揃えます。

いきなり全ページ対応せず、主要LPや主要フォームなど、成果に直結する導線から実装します。

実装後は、サンプルで「想定通りに取れているか」を確認します。

欠損・急変・必須パラメータ不足などを定期点検し、異常時の対応手順を決めます。

週次の“健康診断”として回すと、定着しやすいです。

フォーム送信などの“数”だけでなく、営業工程やスコアなど“質”の情報とつなげると、評価が安定します。

可能なら、意思決定ログ(なぜ判断したか)も残せると説明力が上がります。

テンプレ:LLMO時代の指標マップ(コピペ用)

🗺 指標マップ 3層で整理

指標を増やしすぎると、運用が続かなくなります。

「意思決定で使うか?」を基準に、まずは主要導線と主要KPIに絞る方が、結果として改善が進みやすいです。

🔭未来展望

LLMO×計測は「流入の最適化」から「理解の最適化」へ寄っていく

今後は、ユーザーが情報収集の初期段階でAIを使う場面が増えると考えられます。

そのとき、マーケの評価軸は「流入を増やす」だけでなく、「理解を進める」「比較を後押しする」に広がります。

🧠 指標が“体験”寄りになる

深い閲覧、比較行動、再訪など、理解の進行を示す指標が重みを持つ。

🧾 説明可能性がより重要になる

指標の定義、変更履歴、品質監視が揃っている組織ほど意思決定が速い。

🤖 AI活用が進むほど“データの型”が効く

イベント辞書と命名規約があると、分析や自動化の精度が安定しやすい。

🤝 マーケと営業の接続が評価を決める

成果指標が“数”だけだとブレるため、質や工程とつなぐ設計が鍵になる。

✅まとめ

見えにくい指標を“捨てる”のではなく、“役割を変えて補う”

LLMO時代は、従来の指標が意味を持たなくなるのではなく、単独での解釈が難しくなる場面が増えます。

そこで有効なのが、深い閲覧・比較行動・マイクロCVなどのプロキシ指標です。

これらをイベント辞書と品質監視で支え、接点→行動→成果の三層で整理すると、AI時代でも説明可能な計測に近づきます。

- 検索流入やCTRは役割が変わりやすいため、単独判断は避ける

- 深い閲覧・比較行動・マイクロCVなどのプロキシ指標で補う

- 指標は「接点→行動→成果」の三層で整理すると運用が楽

- イベント辞書と品質監視があると、説明可能性が上がる

まずは主要LP/主要フォームに絞って、比較行動とマイクロCVをイベントとして定義してみてください。

そのうえで、週次の品質点検(欠損・急変・必須パラメータ不足)を回すと、運用が安定しやすいです。

❓FAQ

LLMO×トラッキングでよくある質問

Q検索流入が減ったら、LLMO施策は失敗ですか?

失敗と断定するのは早いです。

AI経由で理解が進むと、来訪は減っても“目的来訪”が増えることがあります。

深い閲覧・比較行動・マイクロCVなどのプロキシ指標と合わせて、接点→行動→成果のどこが変わったかで判断するのがおすすめです。

Qプロキシ指標は何を選べばよいですか?

まずは「意思決定に近い行動」を優先します。

例としては、料金/仕様/導入事例の到達、資料DL、入力開始、動画の一定視聴などが挙げられます。

重要なのは、増やしすぎず、主要導線に関わるものに絞ることです。

Q指標が増えて運用が回らなくなりそうです。

指標は“意思決定に使うか”で絞ると回りやすいです。

まずは主要KPIに対して、補助指標を2〜3個だけ追加するところから始めてください。

週次点検で「使われなかった指標」は削る運用にすると、自然に適正化されます。

Qイベント辞書はどこまで厳密に作るべきですか?

最初から完璧にする必要はありません。

主要イベントだけでも、イベント名・発火条件・必須パラメータ・目的・変更履歴を揃えると、運用のブレが減ります。

“辞書に追加してから実装”をルールにできると、定着しやすいです。

Q成果の評価を安定させるには何が必要ですか?

フォーム送信などの“数”だけでなく、リードの“質”や営業工程と接続すると安定しやすいです。

たとえば、条件合致、スコア、商談化などを成果指標として扱い、プロキシ指標とつなげると説明がしやすくなります。

「IMデジタルマーケティングニュース」編集者として、最新のトレンドやテクニックを分かりやすく解説しています。業界の変化に対応し、読者の成功をサポートする記事をお届けしています。

-7-320x180.png)