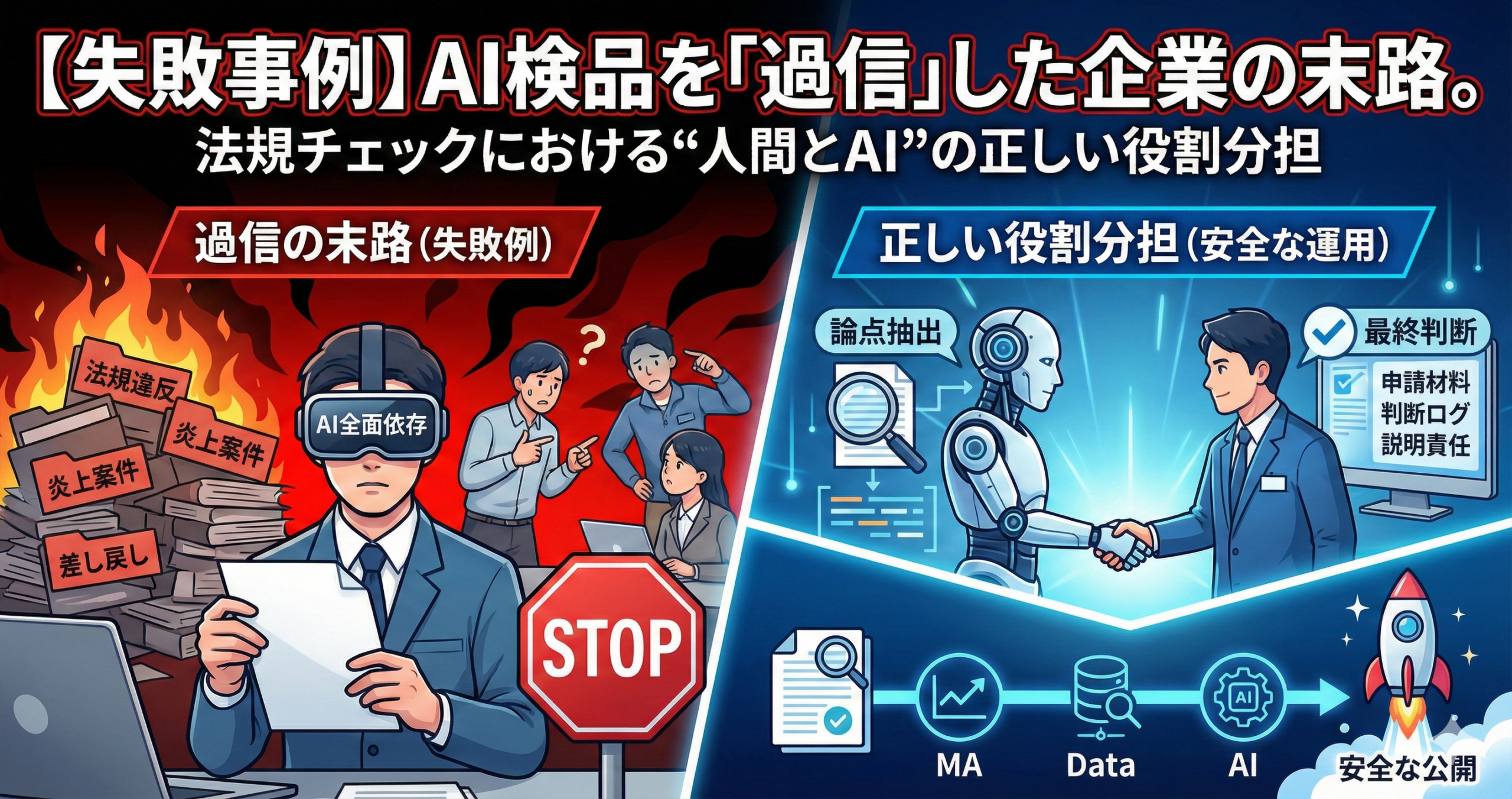

【失敗事例】AI検品を「過信」した企業の末路。法規チェックにおける“人間とAI”の正しい役割分担

「AIで検品すれば、法務チェックの負荷も下がるはず」。そう期待して導入したのに、逆に差し戻しや炎上対応が増えた――。

そんな失敗は、AIの性能不足というより、運用設計の前提がズレたときに起きやすいです。

本記事では、弁護士や法務の視点で重視される「説明責任」と「線引き」を踏まえつつ、現場で回る形に落とし込みます。AIを使う前提で、どこを人が担い、どこをAIに寄せるかを、概念→設計→運用→改善の順に整理します。

イントロダクション

AIを入れたのに事故が増えるとき、原因は「過信」だけでなく、運用が感覚頼みになっていることが多いです。

法規チェックをAIに寄せたときに起きやすい失敗は、「AIが見落とした」よりも、AIに任せてよい前提を作れていないことにあります。

たとえば、チェック対象の粒度が揃っていない、社内ルールが曖昧、承認ログが残らない、例外処理が未設計――こうした状態でAIを入れると、現場は「AIがOKと言ったからOK」という空気になりやすくなります。

しかし法務観点では、最終的に求められるのは「なぜOKと判断したか」を説明できることです。AIは説明の補助にはなっても、説明責任そのものを肩代わりできません。

🧠 感覚頼みになりやすい理由

クリエイティブや文言は、媒体・文脈・表現トーンで意味合いが変わります。

さらに、制作スピードが上がるほど、個別の事情(条件、注意点、対象外)が抜けやすくなります。

その状態でAIの判定だけに寄せると、判断が「結果」だけになり、理由が残りません。

⚙️ MA×データ×スコアリングで変わること

目標は、AIで法規判断を置き換えることではありません。

入口で材料を揃え、AIで論点を抽出し、分岐ルールでチェック深度を切り替え、ログで説明責任を残す。

これにより、法務・現場・DX推進の間で「安全に任せられる範囲」を共有しやすくなります。

事故が起きたあとに残るのは、「誰が」「何を見て」「なぜOKにしたか」が曖昧な状態です。

その結果、チェックが再び全件手作業に戻り、スピードも信頼も落ちやすくなります。

だからこそ、AI導入は“省力化”より先に、責任とログの設計から始める方が安全です。

- AIの失敗は「見落とし」より「任せ方の前提不備」で起きやすい

- 法規チェックは結果より、判断理由と履歴(説明責任)が重要になりやすい

- 入口で材料を揃え、AIは論点抽出、最終判断は人が担う設計が回りやすい

- 例外処理とログがないと、事故後に“全件手作業回帰”が起きやすい

概要

用語は“広告運用と法務の橋渡し”として捉えると理解しやすいです。目的は、判断材料の統一と分岐設計です。

本記事では、法規チェックにおけるAI活用を、MA/オルタナティブデータ/AIスコアリングの組み合わせとして整理します。

ここでのポイントは「法律をAIに解釈させる」ではなく、社内で合意された判断の型に沿って運用を回すことです。

🧩 MA(マーケティングオートメーション)

ここでのMAは配信自動化だけでなく、申請→承認→公開→修正→差し戻しの“検品フロー”を整える基盤です。

法務チェックの属人化は、入口の情報が揃っていないことから始まることが多いです。

申請フォームと差し戻しテンプレを整えると、判断の材料と理由が揃いやすくなります。

🧩 オルタナティブデータ

法規チェックにおけるオルタナティブデータは、「判断に必要な前提と条件」の集合です。

例:商材の注意点、表現NG例、許容されやすい言い回しの範囲、比較の前提、素材の出どころ、第三者関与(提供/依頼/報酬/編集関与)の条件、過去の差し戻し理由など。

重要なのは、根拠だけでなく条件と対象外をセットで持つことです。

🧩 AIスコアリング

AIスコアリングは、法的な“合否判定”の代替ではなく、チェックすべき論点の濃淡を示すための仕組みです。

文章表現の強さ、比較の含み、誤認余地、注記の有無などを材料に、要確認の箇所を提示します。

つまり、AIは「見落としを減らす補助」に寄せる方が安全です。

🔁 三つを掛け合わせると、運用単位で何が変わるか

ターゲティングは、受け手の誤認余地が増えやすい文脈を避ける設計に寄せられます。

優先順位は、外部発信や強い主張の案件を先に深く見る判断がしやすくなります。

ナーチャリングは、差し戻し理由の型に沿って修正が回り、同じ往復が減りやすくなります。

営業連携は、商材の注意点や条件が材料化され、制作側の前提不足が減りやすくなります。

法務が怖いのは、違反そのものだけでなく「説明できない判断」です。

AI活用でも、判断理由と参照材料が残る形にしておくと、慎重派でも運用に乗せやすくなります。

- MAは検品フローの入口を固め、材料と理由を揃えるための基盤

- 判断材料は根拠だけでなく、条件・対象外・履歴を含めて管理する

- AIは合否判定ではなく、論点抽出と深度分岐に寄せる

- 三つの組み合わせで、属人化より“運用の再現性”を作りやすい

利点

法規チェックのAI活用は“省人化”より、“事故の起きにくい運用”に寄せると導入しやすいです。

AI検品を過信して失敗した企業は、「AIがやってくれる」前提で運用を組んでしまいがちです。

一方、安全に寄せる企業は、「AIが得意なこと」と「人が担うべきこと」を分け、再現性のあるフローに落としています。

このとき重要なのは、精度を追うより、判断が揺れにくい仕組みを作ることです。

😣 よくある課題(失敗に繋がりやすい)

AIの結果だけを見て通してしまい、判断理由が残らない。

差し戻しが増え、現場が「結局全部見ないと不安」となり、全件チェックに戻る。

例外処理が未設計で、グレーな案件が増えるほど、現場判断がバラつく。

こうした状態は、事故後の立て直しコストを大きくしやすいです。

✨ 改善されやすいポイント(安全に寄せる)

入口で材料が揃い、AIが論点を示し、人が判断し、ログが残る。

この形にすると、法務は「どこで人が判断したか」を追いやすく、現場は「何を直せばよいか」が分かりやすくなります。

結果として、差し戻しの往復が減り、教育と横展開もしやすくなります。

| 失敗パターン(過信の形) | 起きやすい“末路” | 回避の考え方 | 小さな対策 |

|---|---|---|---|

| AIがOKならOK | 理由が残らず、事故後に説明できない | AIは論点提示、最終判断は人 | 承認画面に「判断理由(テンプレ)」を必須化 |

| 入口の材料がバラバラ | AIも人も判断が揺れ、差し戻し増 | 申請フォームで前提を固定 | 商材条件・注意点・第三者関与を必須項目に |

| 例外処理なし | グレー案件が増え、属人化が悪化 | 例外条件を先に列挙し更新 | 新フォーマットは原則「専門確認」へ |

| ログが残らない | 学習も改善もできず、全件手作業回帰 | 判断履歴を運用資産化 | 差し戻し理由をカテゴリ化し集計可能に |

危険なのは、AIを使うこと自体より、責任の所在が曖昧になることです。

「人が判断したポイント」と「参照した材料」が残る形にすると、運用は安全側に寄せやすくなります。

- 失敗の根は「結果だけ運用」「材料不足」「例外未設計」「ログ欠落」に集まりやすい

- AIは論点提示、人は最終判断、ログは説明責任のために残す

- 精度より、判断が揺れにくい再現性(テンプレ・分岐・履歴)が重要

- 事故後の全件手作業回帰を防ぐには、改善ループが回る設計が必要

応用方法

失敗事例を“再現できる原因”に分解し、回避策を運用に落とします。怖さを、チェックリストに変えるイメージです。

ここでは「AI検品を過信して事故が起きた」という状況を、よくあるパターンに分解します。

実際の事故は会社ごとに事情が異なりますが、運用設計上の落とし穴は似ていることが多いです。

それぞれに対して、MA×データ×スコアリングでどう回避するかを整理します。

🧨 失敗パターン:AIが“合否判定”になっていた

AIの出力が「OK/NG」に近い扱いになり、現場が理由を確認しなくなる状態です。

この形は、事故後に「なぜ通したか」を説明しづらくなります。

回避策は、AIを判定器ではなく、論点抽出器に戻すことです。

🧩 失敗パターン:前提条件がフォームに入っていない

商材の注意点、対象条件、第三者関与、素材の出どころなどが申請に含まれず、AIも人も判断が揺れます。

結果として差し戻しが増え、現場は「AIが役に立たない」と感じやすいです。

回避策は、入口の必須項目を増やすことではなく、判断に必要な前提を固定することです。

🌀 失敗パターン:例外処理が“口頭運用”

新しいフォーマット、強い表現、第三者関与が複雑など、例外が増えるほど口頭判断が増えます。

すると、属人化が強まり、担当者が変わるたびに基準が揺れます。

回避策は、例外条件を先に列挙し、例外の扱いを更新するルールを作ることです。

🧾 失敗パターン:差し戻し理由が曖昧で学習できない

「ここが微妙です」「念のため直してください」の差し戻しが増えると、制作側は何を直せばよいか迷います。

同じ往復が続き、結果的にスピードも安全性も落ちやすいです。

回避策は、差し戻し理由をカテゴリ化し、必要材料とセットで返すことです。

- 主張の強さ:言い切り、断定調、強調語、比較の含み(AIで抽出して要確認)

- 前提条件:対象条件、注意点、対象外(フォーム必須+テンプレで記載位置を固定)

- 関係性:提供/依頼/報酬/編集関与の有無と範囲(申請必須、表示ルールに接続)

- 素材:引用・転載・二次利用の扱い、画像内文字の主張の強さ(素材台帳化)

- 履歴:過去の差し戻しカテゴリ、修正対応、承認理由(ログを資産化)

- 新規性:新フォーマット、新規表現、新規媒体(例外扱いで深度を上げる)

慎重派のチームほど、AIに「判断」をさせるより、AIに「論点」を出させる方が納得されやすいです。

最終判断の責任を人に残しつつ、見落としを減らす補助として使うのが、安全側の設計です。

- 失敗事例は「過信」より、判定化・材料不足・例外未設計・理由未整備に分解できる

- AIは論点抽出、人は最終判断、ログは説明責任の担保として残す

- 特徴量は主張の強さ/前提条件/関係性/素材/履歴/新規性で整理しやすい

- 差し戻しテンプレが整うほど、修正が速くなりやすい

導入方法

導入の成否はツール選定より、責任分界・入口設計・例外設計で決まりやすいです。慎重派が安心できる形に寄せます。

導入を「設計→データ→モデル→運用→改善→ガバナンス」で分解し、チェックリストで示します。

特に法規チェック領域では、まず「人が見る場所」と「AIに寄せる場所」を明示しておくと、現場と法務の合意形成が進みやすくなります。

- 目的を分ける:公開スピード向上/事故予防/説明責任の強化を同時に追いすぎない

- 責任分界を明文化:AI=論点抽出、人=最終判断、法務=基準更新と例外監督(など)

- 優先度(深度)を決める:外部発信、第三者関与、強い主張、新フォーマットは深度を上げる

- 「止める条件」と「通す条件」をセットで書く:曖昧な差し戻しを減らす

- 申請フォームで欠損を作らない:前提条件、注意点、対象外、第三者関与、素材出どころを必須化

- ルールを文章化しすぎない:NG例/OK寄り例/注意例をテンプレとして扱い、参照しやすくする

- 差し戻し履歴を資産化:理由カテゴリ、修正内容、承認理由を残す

- 更新頻度を決める:基準とテンプレを棚卸しし、古い前提を残さない

- AIの役割を固定:合否判定ではなく、論点(強い表現・比較・誤認余地・注記不足)を提示

- 分岐をシンプルに:現場OK/要追記/専門確認(の三段)から始める

- 例外を先に定義:新フォーマット、第三者関与が複雑、主張が強い、素材が特殊など

- AI出力は説明可能な形に:箇所・論点・必要材料・置き換え方針をテンプレ化

- 制作:テンプレに沿って作り、前提条件と注記の記載位置を守る

- 運用担当:申請材料の回収、分岐の運用、差し戻しテンプレでの返却

- 法務/監督者:例外判断の監督、基準更新、教育素材(NG/OK寄り例)の整備

- 営業/事業側:商材条件・注意点・言える範囲を材料として更新し続ける

- CS:誤解や問い合わせの傾向を拾い、注記や表現の改善に反映する

- ドリフト前提:媒体や社会の受け止め方で、誤認余地は変わりやすい

- 誤判定は資産:AIの失敗として捨てず、テンプレや例外条件の更新材料にする

- 差し戻しを原因分類し、頻出から潰す:注記不足/前提不足/表現強すぎ/素材問題など

- 棚卸しを定期化:テンプレと例外が増殖して運用が重くなるのを止める

- ブラックボックス化を避ける:AI出力は“判断理由の代替”にしない(人の理由を必須化)

- 運用負荷の増殖を監視:チェック項目が増えるだけなら統合・削除を検討する

- 過学習“っぽい”兆候に注意:特定表現だけ過度に危険扱いするなら観点を見直す

- 責任の空白を作らない:分岐の境界で、誰が最終判断するかを固定する

AIを「判断者」にしない。人が判断した場所と理由をログに残す。例外を期限付きで管理する。

この三点が揃うと、ツールが変わっても運用の芯が残りやすくなります。

- 導入の鍵は責任分界・入口の必須項目・例外設計・ログ保存

- AIは論点抽出、最終判断は人、説明責任はテンプレで残す

- 差し戻し理由を原因分類すると改善が回りやすい

- 棚卸しがないとテンプレと例外が増殖し、運用が重くなりやすい

未来展望

AIが一般化しても、法規チェックの責任は消えません。だからこそ「標準化できる部分」を増やす方向に進みやすいです。

今後、AIによる文章解析や表現のハイライトは、より一般的になっていく可能性があります。

ただし、法規チェックは文脈や事実関係に依存しやすく、最終判断の責任は組織側に残りやすいです。

そのため、技術の進化に合わせて、「自動化の範囲」より「責任分界とログの標準化」が重要になっていく可能性があります。

🛠️ 標準化されやすい領域

申請フォーム、注記テンプレ、差し戻し理由の分類、承認ログの保存は、再現性のために標準化されやすいです。

AIは論点抽出と分岐の材料として定着しやすいです。

🏢 組織で強く求められやすい領域

法務は「全件を見る」より、基準の更新、教育、例外監督の役割が重要になりやすいです。

DX推進は、運用ログを活かして改善ループを回す役割が強くなりやすいです。

🧠 人が残すべき領域

新しい表現・新しい媒体・第三者関与が複雑なケースは、判断の線引き自体を更新する必要が残りやすいです。

また、リスク許容度は会社の方針にもよるため、最終判断は人が担う設計が現実的です。

🗂️ データで差がつきやすい領域

差し戻し履歴、承認理由、例外条件が蓄積されるほど、判断の揺れが減りやすくなります。

ただし棚卸しがないと、古い前提が残り、逆にリスクが増える可能性もあります。

- 標準化されやすいのは、フォーム・テンプレ・理由分類・ログ保存

- 法務は基準更新と例外監督、DXは改善ループ設計が重要になりやすい

- 新規性が高い領域は、人が線引きを更新する必要が残りやすい

- 履歴資産は強みになるが、棚卸しがないと古い前提が残りやすい

まとめ

AI検品の失敗は“性能”より“設計”で起きやすいです。安全側の役割分担は、運用の芯になります。

AI検品を過信した企業が行き着きやすいのは、事故後の全件手作業回帰です。

それを防ぐには、AIを判断者にせず、論点抽出と深度分岐に寄せ、最終判断を人が担い、ログで説明責任を残すことが重要です。

慎重派の法務やDX推進が納得しやすいのは、「AIを使うこと」ではなく、責任分界と改善ループが設計されていることです。

- 失敗は「過信」より、判定化・材料不足・例外未設計・ログ欠落で起きやすい

- AIは論点抽出、人は最終判断、ログは説明責任の担保として残す

- 入口(申請フォーム)で前提と条件を固定すると、判断の揺れが減りやすい

- 差し戻し理由を型化し、原因分類すると改善が回りやすい

- 例外は期限付きで管理し、棚卸しで基準に取り込むか見直す

- 対象を絞る:事故が起きやすい制作タイプ(外部発信、第三者関与、強い主張)から開始

- 入口を整える:前提条件・対象外・関係性・素材出どころを申請必須に

- AIは論点抽出に限定:箇所・論点・必要追記を出して、三段分岐で回す

- ログを残す:承認理由と参照材料を必須化し、差し戻し理由をカテゴリ化

- 棚卸しを回す:テンプレと例外を定期的に見直し、運用を軽く保つ

- AIは“代替”ではなく“補助”として位置づけると安全側に寄せやすい

- 責任分界・入口設計・例外設計・ログが揃うと、慎重派でも合意しやすい

- 小さく始めて、運用資産(履歴・テンプレ)を積むほど安定しやすい

FAQ

法務/DX推進が不安に感じやすい点を、判断軸と確認事項に落とします。

AI検品は、どこまで任せてよいのでしょうか?

- AI:強い表現、比較、誤認余地、注記不足のハイライト

- 人:最終判断と承認理由の記載

- 法務:基準更新と例外監督

事故が起きたとき、何が一番問題になりやすいですか?

- 承認理由がテンプレで残っているか

- 参照した材料(条件・対象外・注意点)が残っているか

- 例外判断の根拠と期限が記録されているか

AIが「問題なし」と言ったのに、後で差し戻されました。なぜ起きますか?

- 前提条件(対象外・注意点)の欠損をフォームで減らす

- 新フォーマットは例外扱いで深度を上げる

- AI出力を「箇所・論点・必要追記」に統一する

法務が全件確認しないと不安です。現実的な落とし所はありますか?

- 深度:現場OK/要追記/専門確認の三段で開始

- 専門確認は「例外条件」を先に列挙して運用

- 差し戻し理由の分類で、教育とテンプレ改善を回す

差し戻しが増え、現場が疲弊しています。どう改善しますか?

- 原因分類:注記不足/前提不足/表現強すぎ/素材問題/例外条件未整理

- 差し戻しテンプレ:箇所・理由・必要追記・置き換え方針

- 頻出原因はテンプレに吸収し、入口で防ぐ

例外処理が増えて属人化しています。どう管理するとよいですか?

- 例外は“期限付き”で認める(ずっと残さない)

- 例外の理由をテンプレで記録する

- 棚卸しで、例外を基準化するか、運用から外すかを決める

- 慎重派は、AIの判定より、責任分界とログがあるかを重視しやすい

- AIは論点抽出、人は最終判断、例外は期限付きで管理すると安全側に寄せやすい

- 差し戻し理由の型化が、スピードと安全性の両立に効きやすい

「IMデジタルマーケティングニュース」編集者として、最新のトレンドやテクニックを分かりやすく解説しています。業界の変化に対応し、読者の成功をサポートする記事をお届けしています。

-7-320x180.png)