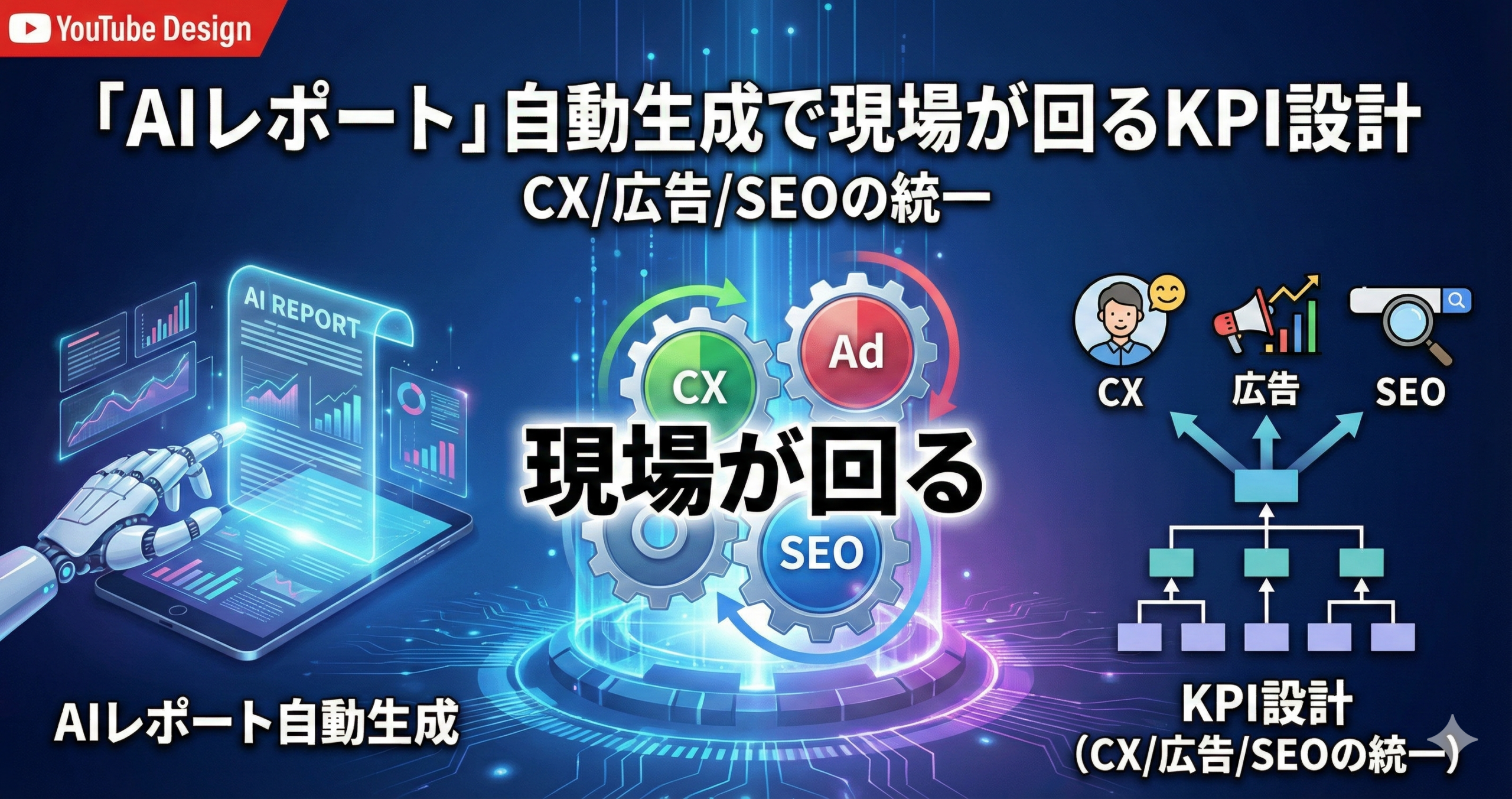

「AIレポート」自動生成で現場が回るKPI設計(CX/広告/SEOの統一)

レポート作成の自動化は「作業を減らす」だけでなく、判断基準を揃えるための装置としても働きます。

本記事では、CX・広告・SEOを同じ言葉で語れるKPIの作り方と、AIレポートが日次運用に馴染む設計の勘所を、概念→設計→運用→改善の順で整理します。

📝 先に結論の方向性

「AIレポート」が回るかどうかは、生成モデルの賢さよりも、入力(KPI定義・粒度・例外)と出力(読む人の意思決定)の接続で決まることが多いです。

イントロダクション

感覚頼みになりやすい「リスト運用」と、AIレポートで変えられるポイントを押さえます。

現場の運用が詰まりやすい場面のひとつが、対象者や優先度を決める「リスト運用」です。

たとえば、広告の配信対象、MAのナーチャリング分岐、営業の追客順、CSの優先対応などは、どれも「誰を、どの順で、どの深さで見るか」という判断の連続です。

ただ、リスト運用は、担当者の経験や“今の空気”に寄りやすい領域でもあります。

その結果、CX・広告・SEOがそれぞれ別の言葉で成果を語り、レポートは「数字の羅列」になり、意思決定のスピードが落ちることがあります。

🧠 なぜ感覚頼みになりやすいのか

判断材料が散らばり、定義が揺れ、例外が増えるほど「手元で丸める」運用になりがちです。

そのまま自動化を進めると、レポートが増えたのに判断が揃わない、という状況も起こりえます。

- 部門ごとに「良い状態」の定義が違う(CXと広告とSEOで言葉がズレる)

- 粒度が揃っていない(ユーザー、セッション、商談、問い合わせなどが混在)

- 例外処理が属人化し、改善の履歴が残りにくい

🧩 MA×データ×スコアリングで何が変わるか

「誰を優先するか」を、運用ルールとして共有できる形に落とすと、AIレポートの出力が安定しやすくなります。

ここで言うスコアリングは、精密な予測よりも、再現性のある優先順位づけを目的にする考え方です。

- 配信や接触の“次の一手”を、分岐ルールとして明文化しやすい

- 営業・CSと合意しやすい「優先度の言語化」が進む

- AIレポートの要約が「理由付き」になり、説明がしやすい

KPI定義 → 運用ルール → AIレポート → 現場の意思決定

- 本記事の前提:AIレポートは「作成の自動化」だけでなく、「判断の統一」のために使う

- 狙い:CX・広告・SEOが同じKPIツリーで会話できる状態をつくる

- 注意:一度に完璧を目指さず、最初は運用が回る最小単位から始める

概要

用語を噛み砕きながら、掛け合わせたときに「運用」単位で何が変わるかを整理します。

用語整理(MA / オルタナティブデータ / AIスコアリング)

ここでは、言葉の定義を「現場での扱い方」寄りに揃えます。厳密な学術定義より、運用に落ちる形を優先します。

🧰 MA(マーケティングオートメーション)

メールやフォーム、コンテンツ接触などを起点に、ユーザーの状態に合わせてコミュニケーションを出し分ける仕組みです。

重要なのはツール名よりも、「分岐の条件」「分岐後の次アクション」「結果の記録」が運用ルールとして残る点です。

- 運用の中心は、シナリオ(分岐)と、判断に使うKPIの定義

- CX・営業との接点が増えるほど、言葉のズレが露出しやすい

🗂️ オルタナティブデータ

自社の一次データ以外も含めて、意思決定の補助に使えるデータ群を指すことが多いです。

ただし、使うべきかどうかは「KPIの定義に寄与するか」「運用負荷が増えすぎないか」で判断するのが現実的です。

- 目的は“情報量を増やす”より、“判断の確度と説明の筋を整える”

- 更新頻度・粒度・結合キーの相性が運用を左右しやすい

🧠 AIスコアリング(現場での捉え方)

スコアリングは、ユーザーや案件の「優先度」を一定のルールで並べるための仕組みです。

現場では、予測モデルの精度を競うより、例外を含めて運用が崩れない設計を先に作るほうが、結果として安定しやすい場面があります。

- しきい値(境界)をどこに置くかより、境界をどう運用に結びつけるかが重要

- 「スコアが高い=必ず優先」ではなく、判断の材料のひとつとして扱う設計が安全

掛け合わせると何が「運用」単位で変わるのか

MA・データ・スコアリングを掛け合わせると、運用は次のように変わりやすくなります。ここで重要なのは、ツール導入よりも、優先順位と分岐の共通化です。

- 掛け合わせの本質は「KPIの共通言語化」と「分岐ルールの共有」にある

- AIレポートは、共通言語が整うほど“読み手が迷わない”出力になりやすい

- データを増やす前に、定義・粒度・例外の設計を固めると運用が崩れにくい

「CX・広告・SEOをつなぐKPIツリー例(上位KPI → 中位KPI → 運用KPIの関係)」

「AIレポートの入出力イメージ(データ→KPI辞書→要約→次アクション候補)」

利点

“精度”より“運用の再現性”に焦点を置き、改善されやすいポイントを整理します。

AIレポートやスコアリングの導入を語るとき、「精度」や「当たり外れ」に意識が向きやすいです。

ただ、実務で効いてくるのは、同じ状況なら同じ判断ができるという再現性のほうだったりします。

🧩 よくある課題

- 属人化:判断の根拠が個人の頭の中に残り、引き継ぎが難しい

- 優先順位のズレ:広告は獲得、SEOは流入、CXは満足で、評価軸が噛み合いにくい

- 温度感の誤判定:今すぐ層と検討層が混ざり、接触が過剰・不足になりやすい

- レポート疲れ:数字は増えるが「次に何をするか」がまとまりにくい

🛠️ 改善されやすいポイント

再現性の観点で設計すると、改善の手触りが出やすい部分があります。

- 共通のKPI辞書により、部門間の言葉のズレを減らしやすい

- 分岐ルールが明文化され、運用の説明がしやすい

- AIレポートが「要約+根拠+次アクション候補」になり、会議が短くなりやすい

- 例外処理をルール化し、改善の履歴として残しやすい

再現性が上がると、何がうれしいか

再現性が上がると、「運用が強くなる」というより、運用が“崩れにくくなる”側面が出ます。

担当者の入れ替わり、施策の増減、季節要因など、変数が多い環境でも、判断軸が保たれやすくなります。

- 議論が「数字の正しさ」から「次の打ち手」へ寄りやすい

- 改善が“勘”ではなく、“ルールの差分”として管理しやすい

- AIレポートの出力品質が安定し、読む側の信頼が積み上がりやすい

応用方法

代表ユースケースを軸に、「どのデータを使い、どう特徴量に落とすか」を概念レベルで整理します。

応用の考え方はシンプルで、「意思決定の分岐点」を見つけ、そこに使える情報を揃えることです。

ここで言う情報は、量を増やすよりも、分岐の根拠として説明できる形を優先すると運用が安定しやすいです。

ユースケース:リード獲得後のスコアで配信シナリオを分岐

代表的なのは、獲得直後の接触設計です。

「すぐ提案して良い層」「まず理解を深めたい層」「静かに観察したい層」など、状態に応じてコミュニケーションを変える発想です。

🧾 使うデータの例(概念)

- 意図のシグナル:資料の閲覧テーマ、FAQの閲覧傾向、問い合わせ内容のカテゴリ

- 関与の深さ:ページの回遊、滞在の偏り、再訪の傾向、動画の視聴のまとまり

- 属性のヒント:業種・職種・利用環境など、判断に必要な最小限の属性

- 接触履歴:メール反応、イベント参加、ホワイトペーパーの選択傾向

特徴量は難しく考えず、「分岐を作るために必要な観点」を先に置くのが安全です。

たとえば「いま比較検討に入っていそうか」「自社の強みと接点があるか」「次の接触に耐えられる温度感か」といった観点です。

- ポイント:分岐を増やしすぎない(運用が追いつく範囲から始める)

- ポイント:例外を先に決める(重要顧客、既存顧客、重複など)

- ポイント:AIレポートは「どの分岐に入ったか」と「根拠」を必ず残す

ユースケース:営業アプローチ順の最適化(判断基準として)

営業連携は、最も摩擦が出やすい領域です。

ここでは「スコアが高いから渡す」と単純化せず、渡す条件を複数の観点で合意するほうが、現場で破綻しにくいです。

🤝 合意しやすい判断軸の作り方

営業の優先度は、単一の数値では表現しづらいことがあります。

そこで、スコアを「優先度の候補」として扱い、追加条件を合わせる設計が現実的です。

- 優先度:関与の深さ(今の関心)

- 適合度:提供価値との相性(解決できそうな課題)

- 準備度:提案に必要な情報が揃っているか(不足ならナーチャリングへ戻す)

- 渡す条件は「MQLの定義」「営業SLA」「戻す条件」まで含めてセットにする

- AIレポートは、営業向けには“短く”、運用向けには“改善観点”を残す

- 判断が割れるケースを、例外ルールとして蓄積し、次の改善に使う

ユースケース:休眠掘り起こし(反応兆候の取り方)

休眠の掘り起こしは、強い売り込みより「兆候を見て、静かに寄せる」設計が向いている場合があります。

重要なのは、“反応があった”の解釈を揃えることです。

🔎 兆候をどう捉えるか(概念)

- 再接触の兆候:特定テーマへの再訪、比較系ページへの集中、問い合わせ手前の挙動

- 関心の変化:以前と違うテーマの閲覧、コンテンツの段階が進む

- 障壁の兆候:料金や導入の条件に関する閲覧が増える、FAQの該当箇所が集中する

- 休眠は「放置」ではなく「適切なタイミング待ち」として扱う設計も選択肢

- AIレポートで“休眠の定義”と“復帰の定義”を明示し、現場で揺れないようにする

- BtoCへの読み替え:購入ではなく「比較」「検討」「解約抑止」など、状態定義を置き換える

導入方法

設計→データ→モデル→運用→改善→ガバナンスに分解し、現場で使えるチェックリストにします。

導入は、ツール選定やモデル作成から入ると、後で手戻りが出やすいです。

先に「何を判断したいか」「その判断を誰が使うか」を固め、AIレポートの出力が意思決定につながる形を作るのがおすすめです。

「導入フロー全体図(設計→データ→モデル→運用→改善→ガバナンス)」

「KPI辞書テンプレ例(名称/定義/粒度/更新/例外/利用先)」

「AIレポートテンプレ例(要約/根拠/異常/推奨アクション)」

設計(目的とKPIの置き方)

- 「上位KPI」と「運用KPI」を分け、会議の目的に合わせて見る層を切り替える

- CX・広告・SEOのKPIは“矛盾しない形”に置く(同じユーザー状態を別角度で見る)

- AIレポートは「誰が読むか」を先に決め、読み手ごとにテンプレを分ける

データ整備(名寄せ・欠損・更新頻度・粒度)

🧹 データは“揃える”が先

データは多いほど良いとは限りません。まずは、同じ意味のデータが同じ形で揃うことが重要です。

AIレポートは入力の揺れに敏感なので、揺れを減らす設計が効きます。

- 名寄せ:ユーザーや企業のキーを定め、統合のルールを残す

- 欠損:欠けたときにどう扱うか(ゼロ扱い/不明扱い/除外)を決める

- 更新頻度:日次で見るもの、週次で十分なものを分ける

- 粒度:ユーザー・セッション・案件など、混ざると誤解が生まれる単位を整理する

- オルタナティブデータは、結合できるキーと更新リズムが合うものから試す

- “正しさ”よりも“ぶれない”を優先すると、運用が継続しやすい

- AIレポート用に、KPI辞書とセットで「データの説明書」を持つ

モデル(スコアの作り方と運用の前提)

モデルは、最初から複雑にしないほうが運用が回りやすいです。

「高い・中間・低い」のような段階での運用から始め、例外を溜めながら調整する設計も現実的です。

🧪 スコア設計の観点(数字を出さない整理)

- スコアの意味:優先度なのか、適合度なのか、準備度なのかを混ぜない

- 根拠の見せ方:説明可能な特徴(閲覧テーマ・接触履歴など)を残す

- 偏りの点検:特定の属性やチャネルに偏った判断になっていないかを見る

- 例外の扱い:重要顧客・既存顧客・重複など、スコアより優先されるルールを先に置く

- スコアは“意思決定の補助”として設計し、現場の裁量を残す

- AIレポートは、スコアの変動だけでなく「変動理由」をセットで出す

- モデルの更新より先に、運用ルール(分岐・例外・責任範囲)を固める

運用(しきい値・分岐・例外処理)

- 運用担当・営業・CSの役割を「見るKPI」「動かす施策」「説明責任」で分ける

- AIレポートは、部門ごとの要約の長さや観点を変える(同じ内容でも見せ方を変える)

- “読むだけレポート”を避け、「次に決めること」が最後に残る構成にする

改善(ドリフト・誤判定・再学習の考え方)

運用が始まると、環境の変化や施策変更で、スコアやKPIの関係が少しずつズレることがあります。

このズレを、責任追及ではなく「設計の更新」として扱えると、継続しやすくなります。

🧭 品質管理の見立て

- ドリフト:以前と同じ基準で見ても、対象者の状態が変わって見える

- 誤判定:高優先なのに反応しない、低優先なのに好反応など、逆転が増える

- 再学習:モデルだけでなく、特徴量や定義(KPI辞書)を見直す必要が出る

- 改善の単位は「モデル」より「運用ルール」と「KPI定義」から始めると手戻りが少ない

- AIレポートは、異常や逆転を“指摘”するだけでなく、“確認ポイント”として出す

- 再学習は頻度より、変更理由と影響範囲が説明できることを優先する

ガバナンス(ブラックボックス化・運用負荷・過学習っぽい兆候)

🧯 リスクと注意点(現場目線)

- ブラックボックス化:理由が説明できないスコアは、現場で使われなくなることがある

- 運用負荷:分岐や例外が増えすぎると、人が追えず形骸化しやすい

- 過学習っぽい兆候:特定の条件だけで極端に判断が寄る、微妙な差で優先度が乱高下する

- 責任の所在:誰が“最終判断”を持つのかを曖昧にしない(AIレポートは補助)

- ガバナンスは“縛る”より、“安心して使える条件”を揃えるイメージが近い

- KPI辞書、運用ルール、例外の履歴をセットで管理し、改善の根拠にする

- AIレポートのプロンプトやテンプレも変更履歴を残し、説明可能性を保つ

未来展望

AIスコアリングとAIレポートが一般化したとき、標準化されやすいものを整理します(断定はしません)。

AIスコアリングやAIレポートが普及すると、「新しい魔法が増える」というより、運用の前提が少しずつ揃っていく可能性があります。

ただし、業種・商材・組織の成熟度で最適解は変わるため、ここでは“起こりやすい方向性”として捉えてください。

🧩 運用の標準化

- KPI辞書が“あるのが普通”になり、定義の衝突が早めに解消されやすい

- レポートが「要約+根拠+次の確認点」という型に寄っていく可能性

- 例外処理が属人化しにくくなり、改善が差分管理になりやすい

🏢 組織の標準化

- 部門横断で“状態”を揃えて語る習慣ができ、連携コストが下がる可能性

- 営業・CS・マーケが同じ定義を共有し、SLAの議論が進みやすい

- 運用の責任分界(AIは補助、人が最終判断)が明文化されやすい

🗂️ データの標準化

データの整備は泥臭い作業ですが、AIレポートが“入力品質”に依存するほど、標準化の価値が上がりやすいです。

- 粒度・更新頻度・欠損扱いが統一され、比較がしやすくなる可能性

- 「何を見れば判断できるか」が整理され、必要以上のデータ収集が減る可能性

- 監査観点(定義・変更履歴・例外)を含むデータ管理が当たり前になる可能性

- 未来の形は一つではなく、まずは“自社にとっての標準”を小さく作るのが現実的

- AIレポートの価値は、読み手の意思決定に直結したときに出やすい

- 標準化の範囲は、運用が回るスピードを優先して段階的に広げる

まとめ

要点を再整理し、明日からの次アクションを「小さく始める」方針で提示します。

AIレポートの自動生成は、導入した瞬間に成果が出るというより、定義と運用ルールが揃ったときに効き始める性質があります。

CX・広告・SEOを統一するKPI設計は、時間がかかる分、整うと運用が崩れにくくなります。

✅ 本記事の要点(再整理)

- AIレポートが回る鍵は、KPI辞書(定義・粒度・例外)と運用ルールの整備

- “精度”より“再現性”に焦点を置くと、現場で使われやすい設計になりやすい

- スコアは最終判断ではなく、優先度の補助として扱うほうが安全に運用しやすい

- 導入は、設計→データ→モデル→運用→改善→ガバナンスの順で手戻りを減らしやすい

- 改善はモデルだけでなく、定義(KPI辞書)と例外の履歴を更新していく発想が有効

次アクション(小さく始める)

- 最初から全社統一を狙わず、影響範囲が小さい領域から始める

- テンプレと辞書を整え、AIレポートの出力を“習慣化”できる形に寄せる

- 改善は「例外の蓄積→ルール更新→辞書更新」を繰り返すイメージで進める

FAQ

初心者がつまずきやすい点を中心に、判断の軸と確認事項をまとめます(断定は避けます)。

何から始めるのが現実的ですか?

まずは「読む人が誰で、何を決めたいか」を一つに絞るのが現実的です。

そのうえで、KPI辞書を最小構成で作り、定義・粒度・例外を揃えると、AIレポートの出力が安定しやすくなります。

- 読む人:運用担当/マネージャー/営業など、ひとつに固定して始める

- 決めたいこと:「優先順位を変えるか」「シナリオを変えるか」など、意思決定を明確にする

CX・広告・SEOのKPIを統一するのが難しいです。どう考えれば良いですか?

完全に同じ指標に揃えるより、「同じユーザー状態を別角度で見る」設計にすると進めやすいです。

上位KPI(状態)を揃え、その状態に効く運用KPIを部門ごとに持つ、という二層構造が扱いやすい場合があります。

- 上位KPI:ユーザー状態の定義(例:検討が進んだ、問い合わせの準備が整った)

- 運用KPI:部門ごとの手段に紐づく指標(広告・SEO・MAの各施策に接続)

どんなデータが必要ですか?データが少なくてもできますか?

まずは「分岐に必要な観点」を置き、そこに最低限のデータを当てるのが現実的です。

データが少ない場合でも、定義と運用ルールが揃っていれば、AIレポートは“判断の筋道”を整える役に立つことがあります。

- 最低限:接触履歴(閲覧テーマ、問い合わせ、メール反応など)

- 次に:属性の最小セット(判断に必要な範囲に限定)

- さらに:外部データは結合キーと更新頻度が合うものから検討

スコアの精度が不安です。導入しても大丈夫でしょうか?

精度不安がある場合は、スコアを“最終判断”に使わず、優先度の候補として運用し、例外ルールを先に作ると安全に始めやすいです。

また、AIレポートに「根拠(どの特徴が効いたか)」と「確認ポイント(迷うところ)」を出す設計にすると、現場の納得感が出やすくなります。

- スコア単独で自動化しない(人の確認ポイントを残す)

- 境界付近の扱い(保留・追跡)を決める

- 例外の履歴を貯め、ルール更新に使う

AIレポートが「それっぽい文章」になるのが心配です。どう防げますか?

防ぐには、入力の型を揃えるのが有効です。KPI辞書(定義・粒度・例外)と、レポートテンプレ(要約・根拠・異常・次アクション候補)を固定し、自由記述を減らします。

また、根拠の出し方を「KPI名+観察された変化+確認すべき点」に寄せると、空疎な文章になりにくいです。

- テンプレを固定し、出力の自由度を下げる

- 根拠を必須項目にする(理由が書けないなら“不明”と出す)

- 数値の羅列ではなく、判断につながる観点に寄せる

営業やCSとの連携がうまくいきません。どこから合意すべきですか?

合意の出発点は「渡す条件」「反応期限」「戻す条件」の三点セットになりやすいです。

特に、戻す条件(まだ早い、情報不足、対象外など)を決めておくと、現場の摩擦が減る場合があります。

- 渡す条件:MQLの定義(状態として言語化)

- 反応期限:SLA(いつまでに何をするか)

- 戻す条件:ナーチャリングへ戻す判断軸

運用が複雑になって続かなそうです。シンプルに保つコツはありますか?

「分岐を増やしすぎない」「例外を安全装置として扱う」「改善を差分管理にする」の三つが効きやすいです。

特に分岐は、運用が追える範囲を超えると形骸化しやすいので、まずは少数の分岐で“回る型”を作るのがおすすめです。

- 分岐は少なく、改善で育てる

- 例外の理由を残し、次回のルール更新に使う

- KPI辞書とテンプレの変更履歴を残す

- FAQの結論が一つに決まりにくいテーマほど、「判断軸」を先に置くと迷いが減りやすい

- AIレポートは、現場の意思決定を補助する前提を崩さないほうが運用が安定しやすい

- 迷ったら「読む人」「決めたいこと」「必要なKPI定義」へ戻って整理する

「IMデジタルマーケティングニュース」編集者として、最新のトレンドやテクニックを分かりやすく解説しています。業界の変化に対応し、読者の成功をサポートする記事をお届けしています。

-7-320x180.png)